Imagínate subiendo en tu coche por una carretera de montaña sin quitamiedos en las curvas más peligrosas. La velocidad te puede molar, pero el riesgo de que te ocurra algo malo puede ser muy alto, incluso mortal. Esta es la situación en la que nos encontramos en el ámbito de la IA hoy: vamos a toda velocidad, , pero si no ponemos límites, el accidente es cuestión de tiempo.

Esta semana quisiera explicarte qué son los guardarraíles en IA, por qué son tan necesarios (diria que imprescindibles) y cómo se aplican en la práctica, sin perjudicar el funcionamiento de los modelos de lenguaje y Agentes de IA.

Para que no te pierdas intentaré ser lo más didáctico que sea posible y darte algunos ejemplos de la vida real. Arranquemos…

¿Qué diablos son los guardarraíles en IA?

Quizás el mejor símil podría ser el de las protecciones en la carretera, los quitamiedos. No están ahí para fastidiarte el viaje, sino para asegurarse de que no te despeñas.

En IA, hablamos de medidas (filtros, reglas, modelos vigilantes…) que evitan que los sistemas hagan o digan cosas que no deberían.Y no hablamos solo de barbaridades obvias como insultos o contenidos ilegales, sino de cualquier desvío que pueda poner en jaque la ética, la seguridad o incluso la reputación de una empresa.Ejemplos reales hay de sobra: un chatbot que, tras ser manipulado, vende coches por 1 dólar; otro que da recetas de bombas caseras si le das el “prompt” adecuado.

Y lo peor es que, sin barreras, estos modelos lo hacen convencidos de estar ayudando.

¿Por qué son más necesarios que nunca?

Porque la IA ya no se limita a responder preguntas triviales; ahora genera textos que parecen escritos por humanos: atiende a clientes, aconseja sobre salud, habla con voz natural y, en breve, tomará decisiones de negocio.

Ahora, los errores ya no hacen gracia, son peligrosos. Por ejemplo, si una inteligencia artificial da un consejo financiero erróneo o revela información confidencial, el problema ya no es técnico: es legal y reputacional. Por eso, los guardarraíles no son opcionales, son literalmente obligatorios.

¿Cómo se instalan estos frenos?

Aquí viene lo interesante. Hay varias formas de construir guardarraíles, desde las más básicas hasta las más sofisticadas. Te lo explico como si armáramos una cebolla de capas de protección:

- Filtros directos: lo más simple. Palabras prohibidas, expresiones sensibles, números que no se pueden decir (como tarjetas o cuentas). Se aplican antes o después del modelo, como un filtro antispam.

- Control semántico: en vez de palabras, mide el significado. Si tu pregunta suena demasiado parecida a algo violento, sexual o fuera de contexto… bloqueo. Requiere un poco más de inteligencia, pero es más efectivo.

- Modelo juez: un “mini-yo” que examina la consulta y decide si es apta o no. Si da luz verde, el modelo principal responde. Si no, se detiene. Es como tener a un moderador invisible.

- Instrucciones internas (prompt engineering): decirle al modelo “oye, tú solo hablas de hoteles, y si te preguntan otra cosa, di que no puedes ayudar”. Fácil de aplicar, pero también fácil de burlar si no se refuerza con más capas.

En la práctica, se combinan todos. Como las lonchas de queso suizo: cada una tiene agujeros, pero juntas bloquean el paso.

¿Y con voz? ¿No es todo más difícil?

Sin duda alguna, ya que la voz introduce nuevos retos: todo ocurre en tiempo real, no puedes revisar antes de que suene y los ataques pueden venir disfrazados de tono urgente o voz falsa.

Por eso, los guardarraíles en este ámbito deben: revisar el contenido antes de convertirlo en audio; transcribir la entrada y analizarla como si fuera texto, detectar emociones o urgencias sospechosas, evitar que el sistema reaccione solo por presión vocal; verificar la identidad (para evitar fraudes por deepfake de voz).

Un ejemplo práctico podría ser un asistente de reservas en un restaurante que detecta insultos, no cancela reservas fuera de la política y bloquea datos personales, como tarjetas. Todo eso en segundos y sin bloquearse. Sin duda, magia

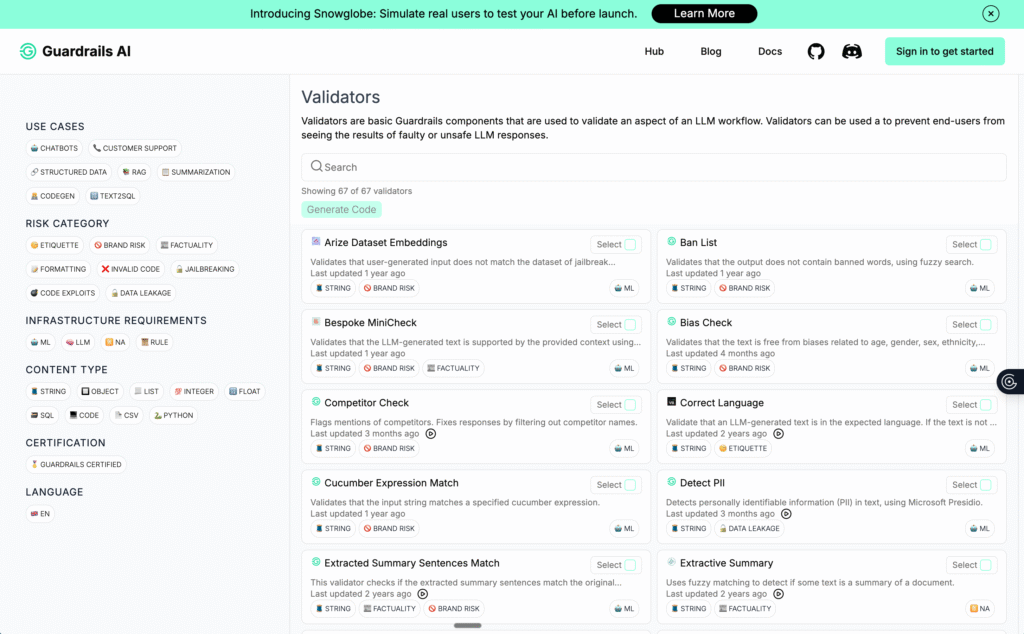

¿Existen herramientas para implementarlos?

Como bien sabéis, hay herramientas para casi todo. Algunas de ellas:

AWS Bedrock y Azure OpenAI ofrecen filtros preconfigurados.

NVIDIA NeMo Guardrails: permite escribir reglas de diálogo en un lenguaje propio (Colang).

GuardrailsAI: enfocado a validar y corregir las respuestas antes de mostrarlas.

Y cada vez más startups están naciendo solo para esto. Porque la necesidad es real.

¿Cómo afinar los guardarraíles?

Cuando activamos los guardarraíles, debemos ajustar sus umbrales (ni tan blandos ni tan duros), por otro lado personalizar según tu negocio (no es lo mismo un banco que un ecommerce), probar a romperlos (como si fueras un hacker), escuchar a los usuarios (y revisar lo que el sistema bloquea o deja pasar), pero sin volver loco al modelo. Se trata de una tarea de precisión.

Esto es como la seguridad informática: nunca está 100% garantizada , pero si tomas medidas, puede ser cada vez más sólida.

Los guardarraíles convierten una IA potente en una IA útil, segura y ética. Y en un mundo donde la IA estará en todos lados, desde el móvil hasta el coche, pasando por la oficina y el salón, necesitamos saber que no se va a salir del camino.

Así que ya sabes: si estás pensando en integrar IA en tu negocio, empieza por definir bien dónde están tus curvas peligrosas, y qué barandillas necesitas poner. Porque innovar sin frenos puede parecer valiente… hasta que te estrellas.

¿Y tú? ¿Ya estás poniendo frenos a tu IA? ¿Te ha pasado que un chatbot diga algo raro o fuera de lugar? Cuéntamelo en los comentarios, me encantará leerte

¡Buena semana!